Le secret des systèmes gagnants avec l’IA : maîtriser le Prompt Chaining

Quand on parle d’intelligence artificielle, beaucoup imaginent un modèle tout-puissant capable de répondre à n’importe quelle question ou d’exécuter n’importe quelle tâche complexe en un seul coup de baguette magique. La réalité est plus nuancée. Demander à un modèle de langage d’analyser un rapport, de sortir les tendances et d’écrire un email en une seule instruction, c’est un peu comme demander à un apprenti cuisinier de préparer un menu gastronomique complet sans recette. Résultat : une partie est réussie, le reste est bâclé.

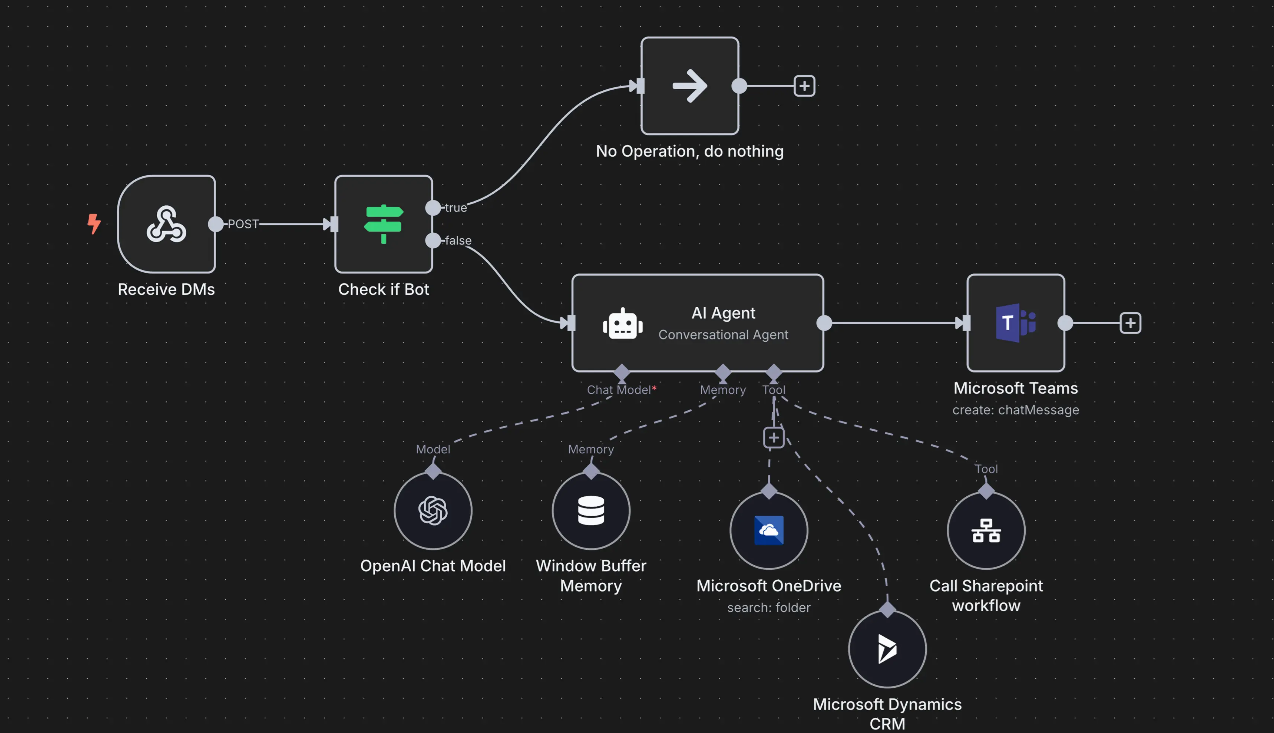

C’est là qu’intervient le Prompt Chaining, ou « enchaînement de prompts ». Plutôt que de confier une mission titanesque à l’IA en un bloc, on découpe le problème en étapes claires, reliées entre elles. Chaque sortie devient l’entrée de l’étape suivante. On construit ainsi un pipeline, un système fiable, précis et surtout contrôlable.

Pourquoi un seul prompt ne suffit pas

Les limites d’un prompt unique sont connues :

- Surcharge cognitive : le modèle perd le fil quand on mélange plusieurs instructions.

- Oublis ou dérives contextuelles : certaines consignes disparaissent en route.

- Propagation d’erreurs : une petite faute initiale se retrouve amplifiée.

Imaginez demander à l’IA : « Résume ce rapport, identifie les tendances, trouve les chiffres clés et écris un mail pour l’équipe marketing. » Elle fera peut-être un bon résumé, mais oubliera la moitié des données ou rédigera un email bancal.

Avec le Prompt Chaining, on procède autrement :

- Étape 1 : Résumer le rapport.

- Étape 2 : Extraire les trois tendances majeures et leurs chiffres.

- Étape 3 : Rédiger un email clair basé sur ces tendances.

Chaque étape est focalisée, simple, et donc plus fiable.

Ce qui fait la force du Prompt Chaining, c’est la modularité. Comme un ingénieur qui assemble des pièces, vous pouvez :

- Optimiser chaque étape indépendamment.

- Contrôler le format des sorties (par exemple en JSON) pour éviter les ambiguïtés.

- Insérer des outils externes (API, bases de données, calculatrice) pour enrichir la chaîne.

Résultat : un système plus robuste, plus transparent et beaucoup plus facile à déboguer.

Des applications concrètes

Le Prompt Chaining n’est pas une théorie abstraite réservée aux ingénieurs. C’est une méthode simple qui se traduit dans la vraie vie par des gains de temps, de clarté et de fiabilité. Pour te montrer la portée de cette approche, voici sept situations concrètes où l’enchaînement de prompts change tout.

Premier cas : transformer de l’information brute en un rapport lisible. Imagine que tu récupères un document dense, comme un rapport de marché ou un PDF client. Plutôt que de demander à l’IA un résumé complet et exploitable d’un seul coup, tu procèdes en étapes : d’abord tu extrais le texte, ensuite tu demandes un résumé ciblé sur les points clés, puis tu fais identifier les chiffres et les dates importantes, avant de terminer par la génération d’un rapport structuré. Résultat : tu obtiens un document clair, sourcé et prêt à être partagé.

Deuxième cas : répondre à une question complexe. Si tu demandes par exemple : « Quelles furent les causes de la guerre mondiale et comment le gouvernement du pays X a-t-il réagi ? », un seul prompt risque de donner une réponse superficielle. Enchaîner les prompts permet d’abord de découper la question en sous-problèmes, de traiter chacun séparément, puis de rassembler le tout dans une réponse synthétique et solide. C’est exactement la logique d’un bon chercheur : analyser étape par étape avant de conclure.

Troisième cas : extraire et fiabiliser des données. Tu as une pile de factures ou de formulaires à traiter ? Demande à l’IA d’extraire les champs essentiels (date, montant, fournisseur), puis fais-lui vérifier si quelque chose manque ou semble incohérent. Si un champ est absent, tu relances uniquement dessus. Ensuite tu normalises les données (par exemple « mille cinquante euros » devient 1050) et tu confies les calculs à un outil externe. À la fin, tu obtiens un tableau propre, sans erreurs, prêt à être importé dans ton CRM ou ton tableur.

Quatrième cas : générer du contenu de qualité. Plutôt que de demander directement un article complet, tu avances par paliers. L’IA propose plusieurs idées, tu choisis la plus pertinente, elle construit un plan détaillé, puis rédige chaque section une par une, en tenant compte du contexte précédent. Enfin, une dernière passe sert à harmoniser le ton et améliorer la fluidité. Ce processus pas à pas permet d’éviter les textes creux et de produire du contenu consistant, beaucoup plus professionnel.

Cinquième cas : animer une conversation qui garde la mémoire. Dans un chatbot de support client, chaque message doit s’inscrire dans un historique : qui est la personne, quel produit elle a acheté, quelle était la dernière étape de son problème. Le Prompt Chaining permet de reconstruire cette continuité à chaque échange. Le modèle n’oublie pas que la personne a déjà demandé un remboursement ou qu’elle attend une confirmation. C’est la différence entre une interaction froide et un vrai dialogue personnalisé.

Sixième cas : écrire et améliorer du code. Ici encore, on progresse par couches : on commence par un pseudocode simple qui décrit la logique, puis l’IA génère une première version fonctionnelle. Une étape suivante permet d’identifier les erreurs ou les points faibles, avant de demander une réécriture ciblée. Enfin, la dernière étape ajoute les commentaires et des exemples d’utilisation. Au lieu d’un code brouillon, tu obtiens un script testé et documenté, prêt à l’emploi.

Septième cas : comprendre des données multimodales. Imagine une infographie qui mélange texte, chiffres et annotations. Demander à l’IA de tout interpréter d’un coup est trop risqué. Avec une chaîne de prompts, tu peux d’abord extraire le texte, ensuite relier les annotations aux bons éléments, puis analyser les chiffres du tableau associé. L’ultime étape consiste à tirer trois ou quatre enseignements concrets, par exemple sur les tendances de ventes ou les risques identifiés.

Ce qui relie tous ces cas, c’est la même logique : diviser la tâche, avancer par étapes, vérifier chaque maillon avant de passer au suivant. Cela transforme une série d’actions incertaines en un processus fluide et maîtrisé. Le Prompt Chaining, ce n’est pas de la technique pure, c’est avant tout du bon sens appliqué à l’IA.

Au-delà du prompt : l’ingénierie du contexte

Le Prompt Chaining ouvre la voie à une pratique encore plus stratégique : l’ingénierie du contexte. L’idée est simple : plus l’environnement que vous fournissez au modèle est riche, plus ses réponses seront pertinentes.

Cela implique :

- Des instructions précises sur le rôle du modèle (ex. « Tu es analyste financier »).

- L’intégration de documents pertinents (rapports, notes de réunions).

- L’appel à des outils externes (API temps réel, bases clients).

Plutôt que de poser une question brute, on construit un véritable écosystème d’information dans lequel l’IA peut agir avec intelligence.

Trois conseils pratiques pour vos propres systèmes

- Découpez toujours vos tâches : si une demande dépasse deux ou trois actions distinctes, transformez-la en chaîne.

- Standardisez vos sorties : imposez des formats (tableaux, JSON) pour que chaque étape reste claire et exploitable.

- Testez et ajustez chaque maillon : corrigez d’abord le problème d’une étape avant de vouloir tout optimiser.

Le Prompt Chaining n’est pas qu’une technique pour geeks de l’IA. C’est une véritable philosophie de travail : diviser pour mieux régner. Au lieu de subir les limites d’un modèle qui s’éparpille, on lui donne un chemin clair, étape par étape. Résultat : des systèmes plus fiables, plus performants et surtout plus utiles au quotidien.

Dans un monde où l’IA devient un partenaire de travail incontournable, maîtriser ces principes, c’est déjà prendre une longueur d’avance.

👉 Si cet article vous a été utile, abonnez-vous à ma newsletter Système Gagnant et à ma chaîne YouTube. J’y partage chaque semaine des méthodes concrètes pour créer vos propres systèmes, sans bullshit, avec des résultats réels.