Écrire de (vrais) prompts qui s'avèrent efficace en phase de production

Une démo qui brille n’a jamais payé une facture. Ce qui transforme un essai d’IA en résultats, c’est un prompt écrit comme un composant de production : un rôle clair, des consignes nettes, des exemples pertinents, un format de sortie verrouillé, et des mesures simples pour décider si l’on publie… ou si l’on réécrit. Rien d’ésotérique, juste de la rigueur.

Ce que “prompt” veut dire quand on parle d’entreprise

Trois façons de s’adresser à un modèle coexistent:

- Le zero-shot, c’est poser la question “à froid”. C’est utile pour explorer, mais la variance est forte : la même requête peut produire trois styles différents à deux minutes d’intervalle.

- Le single-shot ajoute un repère : une entrée et une sortie d’exemple qui donnent le ton et le format. C’est déjà mieux pour un email court, un résumé, une note.

- Le few-shot, enfin, assemble plusieurs exemples ( bons et mauvais ) pour verrouiller un style, un schéma et des règles métiers. Dès que la sortie est ingérée par un workflow (CSV, JSON, API), ou que la conformité compte, il faut passer en few-shot. Le coût est modeste : quelques lignes de plus dans le prompt pour des résultats stables et intégrables.

Commencer sans tourner en rond

Bloqué ? Demandez au modèle de produire un premier prompt à votre place. Oui, un prompt pour générer le prompt. On obtient une V1 correcte en une minute, puis on la raffine : on nomme les variables, on écrit les contraintes, on fixe ce que l’outil a le droit de faire seul et quand l’humain reprend. Détail qui compte : faites écrire ce brouillon par le même modèle que celui qui sera utilisé en production. Les affinités de style existent, inutile de lutter contre. Chatgpt ecrira un prompt pour Chatgpt, Claude pour Claude, etc....

Le "system prompt" cadre le jeu, il ne sauve pas un mauvais brief

Le role du "system prompt" qu'on trouve dans les agents n8n par exemple est de définir la posture ( par exemple on peut ecrire: conseiller sobre, pas d’hyperbole, sources indiquées, “INCONNU” si l’information manque ).

Il stabilise le ton, impose des interdits, rappelle le format de sortie. Mais il ne remplace pas des instructions vagues. Ce qui fait la qualité d’une réponse, ce sont des consignes exploitables et des exemples concrets qui montrent exactement ce que vous attendez.

La forme n’est pas cosmétique : elle guide le modèle

Les LLM “entendent” mieux des consignes structurées que de longues explications. Des sections balisées (SYSTEM, INSTRUCTIONS, EXEMPLES, FORMAT), quelques mots en capitales pour signaler des obligations (MUST, REQUIRED), des contraintes posées une par ligne plutôt qu’un paragraphe confus, et surtout des contre-exemples qui disent explicitement quoi ne pas faire. Trois petites touches de forme, et l’ambiguïté disparaît.

Mesurer sans usine à gaz

On ne “devine” pas la qualité d’un prompt. On la mesure. Prenez un échantillon de cas réels ( dix à trente suffisent ) et suivez quatre indicateurs : pourcentage de sorties au format attendu (JSON valide), exactitude des champs par rapport à la vérité terrain, temps de retouche humaine en minutes, et précision des escalades quand des règles existent. Fixez des seuils de mise en production : 95 % de JSON valide, 92 % d’exactitude, deux minutes de retouche maximum, moins de 3 % de faux négatifs sur l’escalade. Dans le cycle d’itération, on ne change qu’une variable à la fois ( format, exemple, consigne ) puis on re-mesure. Au bout de trois runs, on gèle la version et on publie. C’est simple, et ça suffit.

Jeu de test : 30 cas réels

Métriques : success_rate_json | exactitude_champs | correction_time_min | escalate_precision

Seuils : JSON ≥ 95% | Exactitude ≥ 92% | Retouche ≤ 2 min | FNR escalade ≤ 3%

Itération : 1 variable modifiée par run | 3 runs max | versionning vX.Y + changelogDeux prompts des agents n8n qui font la différence

1) Triage support avec escalades explicites

Le flux n8n est direct : déclencheur email, bloc LLM pour la décision, condition IF pour les règles, normalisation JSON, création ou mise à jour de ticket via HTTP, puis journalisation des métriques dans un tableur. Le prompt, lui, tient en une page. Il pose le rôle ( assistant de triage sobre, décision justifiée en une phrase ), rappelle les règles ( facturation au-delà de dix mille euros, juridique, clients VIP ), montre un bon exemple, précise un mauvais à ne pas suivre, et impose un format simple : catégorie, priorité, escalade vrai/faux, raison. Si la sortie n’est pas un JSON valide, l’agent renvoie “INCONNU” et déclenche l’escalade humaine. Rien de plus.

[SYSTEM] Assistant de triage. Sobre. Pas d'emphase.

[INSTRUCTIONS] À partir du ticket et des règles, classe et décide l'escalade.

Règles: Facturation ≥ 10k€ ⇒ escalade:true | Juridique ⇒ escalade:true | VIP ⇒ priorite:"Haute"

Bon exemple:

Entrée: "Client PRO, facture erronée 12k€, remboursement"

Sortie: {"categorie":"Facturation","priorite":"Haute","escalade":true,"raison":"Montant ≥10k€"}

Mauvais exemple: texte libre, pas de JSON, champs manquants.

FORMAT OBLIGATOIRE:

{"categorie":"string","priorite":"Basse|Moyenne|Haute","escalade":true|false,"raison":"string"}2) Prospection “preuve d’intérêt”, moins de volume, plus de réponses

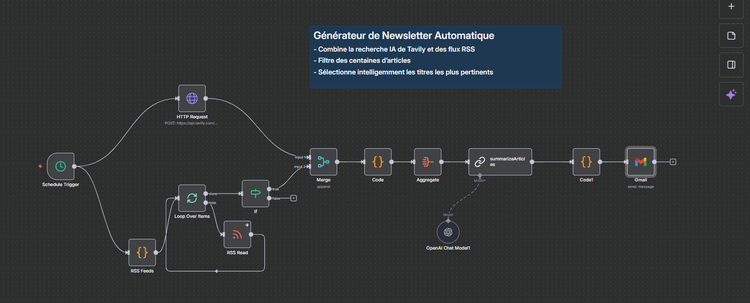

La prospection utile ne bombarde pas ; elle cite un fait vérifiable et respecte la personne. Dans n8n : un agent fait la veille (site, LinkedIn, actualités), un bloc de nettoyage nettoie les signaux, le LLM rédige un email sobre de cent mots, et un garde-fou bloque l’envoi s’il ne détecte aucun fait sourçable. Le prompt exige un sujet court, une formulation simple, un appel à l’action net, et bannit les superlatifs. La réputation remonte, le taux de réponse aussi.

[SYSTEM] Rédacteur sales. 90–110 mots. Sobre. 1 fait vérifiable minimum.

[INSTRUCTIONS] Écrire un email à partir des Faits fournis. Pas de superlatifs. CTA clair.

Contre-exemple (à éviter): "On révolutionne votre ROI"

Bon exemple: "Vous avez ouvert l'agence de Lyon en juin ; notre outil vérifie les devis multi-sites."

FORMAT:

Sujet: {10 mots max}

Email: {2 phrases + CTA}Éviter les pièges qui coûtent du temps

Le premier piège, c’est le prompt fourre-tout qui demande d’analyser, décider et produire dans une seule traite. On découpe : d’abord classer, puis choisir, puis écrire. Le deuxième, c’est demander “un avis” quand on attend une extraction structurée. On nomme les champs et on impose un schéma. Le troisième, c’est tolérer l’invention en cas de doute : on interdit l’approximation et on exige “INCONNU” avec une escalade humaine. Enfin, on fuit les sorties libres quand il faut un JSON propre. Pas de schéma, pas d’intégration. Pas d’intégration, pas de valeur.

Gouvernance légère, effets durables

Un bon prompt vit dans un cadre simple : des droits et des limites (“ce que l’agent a le droit de faire seul”, “quand l’humain reprend”), de la traçabilité (version du prompt, métriques suivies, échantillon de test), et un rituel de diffusion. Publier une page « avant / après » par cas d’usage aligne tout le monde : on voit la ligne de base, on voit le gain, on sait si ça vaut la peine d’étendre.

Ce qu’il faut retenir

Le style compte, mais la structure compte davantage. Des exemples bien choisis valent mille explications. Sans évals, on se raconte des histoires ; avec quatre métriques et un cycle court, on passe de la démonstration à la production. Tenez cette discipline deux ou trois itérations, geler la version, publier, mesurer. La qualité monte, les retouches baissent, et la valeur devient visible — sans promesse creuse, sans grand soir.